智源研究院发布全球最大中英文向量模型训练数据集

发布时间:2023-09-19

发布时间:2023-09-19

信息来源:中关村科学城微信公众号

字体:

大

中

小

信息来源:中关村科学城微信公众号

字体:

大

中

小

打印

打印

发布时间:2023-09-19

发布时间:2023-09-19

信息来源:中关村科学城微信公众号

信息来源:中关村科学城微信公众号

9月15日,北京人工智能产业峰会暨中关村科学城科创大赛颁奖典礼现场,智源研究院发布面向中英文语义向量模型训练的大规模文本对数据集MTP(massive text pairs)。

这是全球最大的中、英文文本对训练数据集,数据规模达3亿对,具有规模巨大、主题丰富、数据质量高三大特征,旨在推动解决中文模型训练数据集缺乏问题,推动人工智能协同创新发展。

通用语义向量模型是决定大模型性能的关键组件,可以链接外模型与外部知识;而由“关联文本”为基本元素的优质训练数据,是构建通用语义向量模型的核心要素。本次开源的MTP数据集为智源BGE中英文语义向量模型训练所用中英文数据。

北京智源研究院副院长兼总工程师林咏华在发布环节中表示:“语义向量模型在大模型落地产业中起到十分重要的作用,但往往被忽略了。我们希望这次大规模数据集、以及语义向量模型的开源,能帮助更多团队加快实现大模型产业落地。”

得益于大规模、高质量的训练数据,开源可商用的智源BGE模型,自发布以来,即凭借优秀的中英文语义检索精度与整体语义表征能力成为广受社区欢迎的语义向量模型:

大规模向量模型权威排行榜 MTEB上排名稳居第一;在全球知名的人工智能开源社区Hugging Face累计下载量达到数十万;被 LangChain等全球多个知名开源项目集成。

伴随2022年末ChatGPT 横空出世,全球大模型研发进入如火如荼的爆发期,而激烈的竞争与高昂的成本,也同时推动着开源崛起成为人工智能发展的关键推动力量。

标志性的事件是今年5月在全球人工智能圈广为流传的一篇Google内部文件,声称“开源AI将击败谷歌和OpenAI”;来自Meta的代表性开源模型 Llama则对当前产业发展起到至关重要的作用。

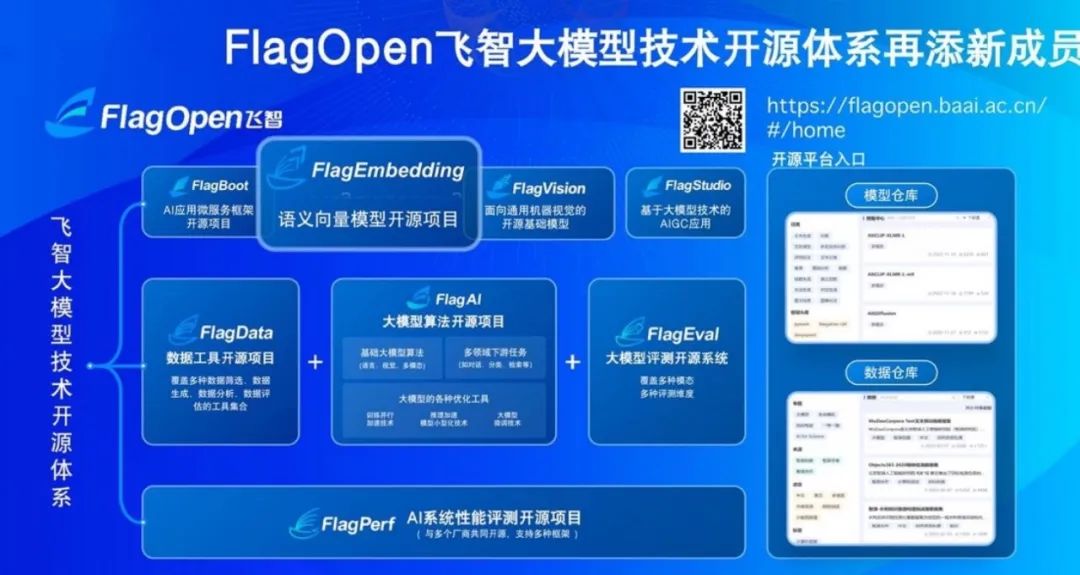

作为中国大模型开源生态圈的代表机构,智源正在着力打造FlagOpen飞智大模型技术开源体系,引领共建共享大模型时代的“类Linux”开源开放生态。

上线于2022年11月,正式发布于2023年2月,FlagOpen飞智大模型技术开源体系先见性地引领着中国大模型开源生态建设与发展。

在今年2月的FlagOpen飞智发布会上,智源研究院院长黄铁军表示:“人工智能时代,开源开放生态,是唯一的出路。”他认为:“智能时代需要真开源,不是安卓那样的利用开源,不是某一企业控制的开源,而是完全在开源社区发展的大家的开源,就像Linux、RISC-V和2022年完全转入开源社区的PyTorch。……大模型时代需要这样的开源,也只有这样的开源体系,成为哺育智能之树蓬勃生长的大地母亲。”

除了新增的FlagEmbedding语义向量模型开源项目板块,FlagOpen还包括大模型算法、模型、数据、工具、评测等重要组成部分,致力于打造大模型时代的 AI 技术基础设施,未来将持续向学术界和产业界开源更为完整的大模型全栈技术。

数据对大模型训练起着至关重要的基础作用。构建高质量开源数据集,特别是用于训练基础模型的开源数据集对大模型发展意义重大,然而中文社区却鲜少数据开源贡献者。

日前,在2023年国家网络安全宣传周活动上,北京智源人工智能研究院院长黄铁军表示:“数据可以说是AI大模型最重要的一个要素,大家认识不同,但是总的来说几乎所有人都认为数据的质量对模型智能水平影响最高,差不多要超过60%。”

智源持续进行包括数据在内的大模型全栈技术开源,持续贡献高质量中文数据集建设与数据资源开源开放。

2021年,智源推出全球最大语料库WuDaoCorpora,开放200GB高质量低风险中文语料,由400余个产学研单位合作,已有770多个研发团队申请,为微软、哈佛大学、斯坦福大学、华为、阿里巴巴、腾讯、鹏城实验室等提供数据服务,有效支撑全球大模型相关研究。

今年开放的最大规模、可商用、持续更新的中文开源指令数据集COIG,由来自全球40余个机构的100多名工程师共同参与,创造了跨越国界、紧密合作的全球数据开源动人故事。

目前,智源亦在推动各方共建大规模高质量中文数据库,以盘活我国高质量中文数据资源,加快数据处理相关标准、技术、工具和支撑平台研发,提高数据处理效率。

相关人物